Notre guide complet de l’HDR

Si vous avez envisagé d’acheter une nouvelle télé ces dernières années, vous avez certainement été bombardé du glorieux acronyme de trois lettres qu’est l’HDR. Acronyme de « High Dynamic Range », l’HDR est un type de technologie d’affichage qui vise à rendre ce que vous voyez à l’écran plus réalise et plus proche de ce à quoi ressemblent les choses dans la vraie vie. Cela se fait à base d’un contraste amélioré, d’une gamme plus importante et plus précise de couleurs, et d’une luminosité supérieure – et elle arrive enfin sur PC.

L’HDR sur PC est un peu plus compliquée que dans le monde des télés, avec une variété de différents standards, des soucis de compatibilité, et une grande propension de Windows 10 à compliquer la chose. Dans cet article, je vais vous expliquer ce que fait l’HDR et ce qu’elle est en réalité, ce qui fait qu’elle rend vos jeux plus beaux, ainsi que les cartes graphiques, écrans, et jeux PC dont vous avez besoin pour en profiter.

Qu’est-ce que l’HDR ?

Oubliez la 4K. L’HDR est, selon moi, la chose la plus intéressante à s’être produite dans le monde de l’affichage depuis l’époque où de petites vis servaient à faire tenir nos câbles d’écran. Comme je l’ai mentionné plus haut, l’HDR sert à rendre l’image plus naturelle via des blancs plus lumineux, des noirs plus sombres, et tout un tas de splendides couleurs entre les deux que nous n’avons pas lorsque nous utilisons la SDR (ou standard dynamic range).

Le point le plus important de l’HDR est l’augmentation de la luminosité. Sans elle, vous perdez le contraste, ou « dynamic range » qui est si vital à la façon dont nos yeux perçoivent habituellement le monde qui nous entoure. Si vous avez déjà pris une photo pendant une journée nuageuse et que le ciel était tout blanc, même si vous-même voyiez clairement les nuances de gris des nuages, c’est parce que l’objectif de votre appareil photo n’est pas capable d’interpréter autant de données sur la lumière de la même façon que nos yeux le font.

C’est la même chose pour les écrans et télés SDR. L’HDR vise à rectifier ce problème, en affichant des images aussi proches que possible de ce que vous verriez dans la vraie vie. Cela implique donc des ciels et horizons bien plus jolis et détaillés, avec des couleurs vives et claires, plutôt qu’un gros amas de blanc, et une gradation plus précise du sombre au lumineux lorsque vous traversez des zones d’ombre.

En quoi l’HDR affecte la luminosité ?

La luminosité globale d’un écran dépend très largement de la complexité de son rétroéclairage. Dans un écran LCD, le rétroéclairage est la partie de l’écran qui illumine les pixels à l’avant de celui-ci pour afficher des couleurs, et il est généralement composé de LED, qui sont la raison pour laquelle les télés sont souvent appelées TV LCD LED. De nos jours, la plupart des écrans sont éclairés par les côtés, via des LED placées sur les bords de l’écran.

Les meilleures télés ont cependant abandonné cette disposition au profit de petites zones de rétroéclairage formant un quadrillage. Ces TV sont souvent appelées « full array local dimming », et elles ont de bien meilleures capacités à afficher correctement ce qui se trouve à l’écran, en diminuant la luminosité dans les zones les plus sombres de l’image pour que les plus brillantes ressortent, comme un lampadaire ou les étoiles dans la nuit. Plus un écran a de zones d’éclairage plus il sera précis pour dépeindre ce qui se passe à l’écran tout en maintenant ce sens fondamental du contraste et de la gamme dynamique.

La bonne nouvelle est qu’on commence enfin à voir arriver des écrans PC capables de ça. L’Asus ROG Swift PG27UQ et l’Acer Predator X27 ont tous deux 384 zones de rétroéclairage, et le ridiculement large Samsung CHG90 également – bien que le nombre exact ne soit actuellement connu que par les ingénieurs de Samsung.

Cette image ne rend pas vraiment justice au X27 (à droite) par rapport à la réalité, mais la différence dans la façon dont il gère les scènes de nuit par rapport à un écran SDR classique (à gauche) reste frappante.

Disposer de nombreuses zones de rétroéclairage, c’est très bien, mais le point clé à chercher est la luminosité réelle qu’ils peuvent atteindre. Encore une fois, si on prend les télés comme point de départ, les meilleurs (ceux qui sont actuellement identifiés par le logo Ultra HDR Premium) peuvent atteindre un splendide 1000 cd/m² (ou nits, comme le disent certains). Votre télé SDR moyenne, quant à elle, n’atteint probablement une luminosité maximale que d’environ 400-500 cd/m². Les écrans SDR de leur côté ne dépassent que rarement 200-300 cd/m².

C’est là que les choses se compliquent, car j’ai vu plusieurs écrans annoncer une compatibilité HDR sans atteindre de tels niveaux d’intensité lumineuse.

Les meilleurs actuels – l’Asus PG27UQ et l’Acer Predator X27 – atteignent 1000 cd/m² comme les télés concurrentes, les Ultra HD Premium. C’est aussi ce que Nvidia cherche à atteindre avec son standard G-Sync HDR (dont le PG27UQ et le X27 font partie), et c’est aussi l’un des standards DisplayHDR de VESA, le bien nommé VESA DisplayHDR 1000.

VESA a cependant également des standards HDR plus bas pour les niveaux de luminosité 600 cd/m² et 400 cd/m² – VESA DisplayHDR 600 et VESA DisplayHDR 400. Ceux-ci seront certainement les plus communs dans le monde du PC, et j’ai déjà commencé à voir plusieurs écrans de chez AOC et Philips commencer à les adopter.

Encore une fois, c’est difficile à voir sur une photo, mais croyez-moi, c’est le MEILLEUR Cup Noodle que vous n’avez jamais vu…

Une luminosité plus faible implique cependant naturellement que l’impact global de l’HDR sera plus faible, et étant donné que la plupart des écrans PC SDR peuvent déjà atteindre environ 300 cd/m², je dirais que 100 cd/m² de plus ne feront pas une différence majeure.

De fait, si vous envisagez de vous procurer un écran HDR, je vous recommande vivement d’en trouver un qui, idéalement, atteigne 1000 cd/m², ou 600 cd/m² au strict minimum. Autrement, vous serez très certainement déçu. Ces écrans seront naturellement plus chers que les 400 cd/m², mais si vous voulez vraiment profiter de l’HDR, vous ne vous rendrez pas service en prenant quelque chose de moins bon.

En quoi l’HDR affecte la couleur ?

Bien sûr, l’HDR ne joue pas uniquement sur la luminosité. Le but est également d’afficher un panel de couleurs plus large pour plus de réalisme. De bien des façons, la luminosité et la qualité des couleurs sont très liées, car du fait de la façon dont nos yeux fonctionnent, plus quelque chose est lumineux, plus on le perçoit comme coloré.

Mais oublions la luminosité pendant un instant, il y a deux principaux ingrédients dont l’HDR a besoin pour des couleurs améliorées. Le premier est la profondeur des couleurs (bit-depth) de la dalle, et le second est la gamme de couleurs que l’écran est capable d’afficher – c’est ici que les gamuts de couleurs entrent en jeu. (Je vais vous avertir maintenant – vous allez bientôt voir des GRAPHIQUES pour illustrer mes propos, donc préparez-vous pour tout un tas de couleurs pétantes).

Par exemple, pour qu’une télé soit classée Ultra HD Premium TV, elle doit avoir une dalle avec au moins des couleurs 10-bit et atteindre au moins 90 % de couverture du gamut DCI-P3.

Parlons tout d’abord de la profondeur. Sans entrer trop dans les détails techniques, le point le plus important à comprendre est que la plupart des écrans utilisent aujourd’hui des dalles 8-bit, qui peuvent afficher 16,78 millions de couleurs (parfois appelés 24-bit ou True Colour). Vous pourriez vous dire que c’est déjà bien, jusqu’à ce que vous preniez conscience que les dalles 10-bit (parfois appelées 30-bit ou Deep Colour) peuvent afficher 1,07 milliard de couleurs.

Far Cry 5 est vraiment très joli en HDR sur le Samsung CHG90

C’est sur ce point que les écrans PC sont à la traine. Même Nvidia a admis que leurs dalles G-Sync HDR sur l’Asus ROG Swift PG27UQ et l’Acer Predator X27 ne sont en réalité techniquement que des dalles 8-bit qui simulent une qualité 10-bit via un processus nommé « 2-bit dithering » plutôt que de vraies dalles 10-bit, et vous trouverez des situations similaires avec le standard DisplayHDR de VESA. VESA indique qu’un écran ne doit avoir qu’un écran 8-bit réel (le 6-bit + 2-bit dithering de certains écrans ne suffit pas ici) pour obtenir l’appellation HDR. Si votre dalle est 8-bit + 2-bit, elle est encore meilleure.

Personnellement, le souci du 8-bit + 2-bit ne m’inquiète pas trop. Ayant vu l’Asus PG27UQ de près, je peux vous assurer qu’il est vraiment très convaincant et rivalise facilement avec n’importe quelle Ultra HD Premium TV. Quoi qu’il en soit, même si les écrans PC ne sont pas encore réellement 10-bit pour l’instant, une dalle 8-bit + 2-bit restera certainement meilleure qu’une dalle simplement 8-bit, ce qui en fait un point supplémentaire à vérifier lors de votre choix.

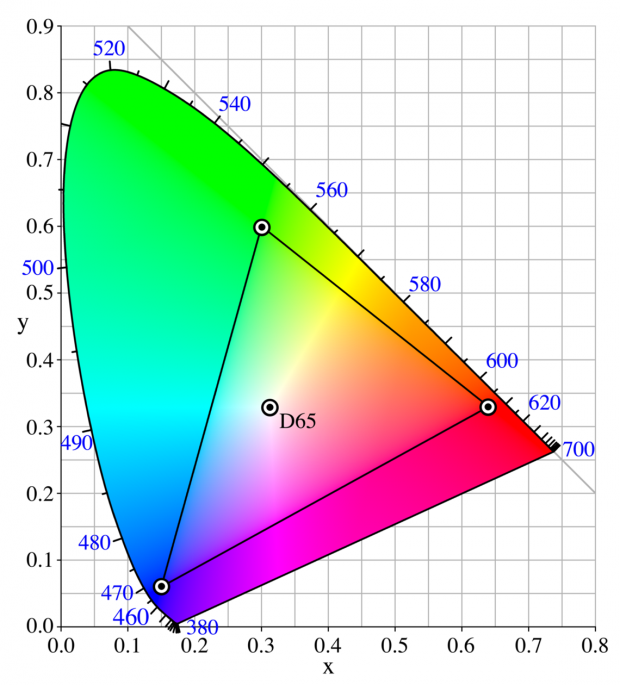

Voici le diagramme de chromaticité CIE 1931, qui affiche toutes les couleurs connues dans notre spectre de couleurs. D65 est blanc, et le triangle interne représente les limites du gamut colorimétrique sRGB.

En effet, le nombre de couleurs qu’un écran est capable de produire aura un effet sur sa couverture globale. La plupart des écrans SDR sont configurés pour afficher les couleurs du gamut colorimétrique sRGB. C’est une petite portion (environ 33 %) de toutes les couleurs qu’un œil humain est capable de percevoir, et ressemble largement au nombre de couleurs visibles dans la nature – connues sous le nom de gamut de Pointer, qui ne représente lui-même qu’un peu moins de la moitié de toutes les couleurs connues (ou chromaticités) dans le spectre de couleurs global.

Jusqu’à aujourd’hui, le sRGB s’est montré tout à fait suffisant pour les tâches informatiques quotidiennes. Il a, après tout, été créé par Microsoft et HP dans le milieu des années 90 dans ce but précis. Mais les écrans HDR visent maintenant un gamut colorimétrique bien plus large connu sous le nom de DCI-P3. Couvrant environ 45 % de toutes les couleurs connues, et une portion bien plus importante du gamut de Pointer (87 % contre 69 % pour le sRGB), ce standard a été créé par plusieurs des plus grands studios de cinéma actuels pour le cinéma numérique (DCI signifie Digital Cinema Initiatives).

Le principal avantage qu’a le DCI-P3 sur le sRGB est sa couverture plus étendue des rouges et verts, qui est importante, car ces couleurs sont celles pour lesquelles nos yeux sont les plus sensibles dans des conditions d’éclairage normales. Son point bleu le plus éloigné est exactement le même que celui du sRGB, et c’est la couleur à laquelle nous sommes le moins sensible.

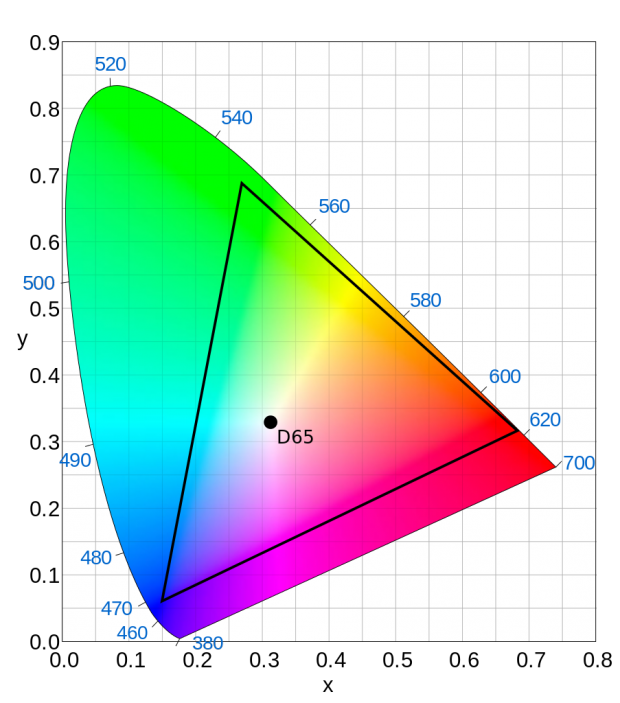

Un plus grand triangle cette fois, représentant le gamut colorimétrique DCI-P3. Il est 25 % plus grand que le gamut sRGB et étend la couverture des verts et rouges.

Comme je l’ai mentionné plus haut, les meilleures télés doivent couvrir au moins 90 % du gamut colorimétrique DCI-P3, et cette règle est largement adoptée par les écrans PC – à la fois par les spécifications Nvidia G-Sync HDR et les standards VESA DisplayHDR

Vous pourriez également avoir entendu parler de Rec. 2020. Celui-ci est un autre (mais pas seulement) gamut colorimétrique encore plus étendu que le DCI-P3 – environ 63 % de toutes les couleurs connues et environ 99,9 % du gamut de Pointer – et il fait également partie des spécifications minimales des télés Ultra HD Premium TV.

Cependant, bien que de nombreuses télés Ultra HD Premium TV soient compatibles avec le standard Rec. 2020, cela ne signifie pas forcément qu’elles sont capables de l’afficher. En effet, pour le moment, il n’existe aucun écran – et encore moins disponible à l’achat – capable de produire ne serait-ce que quelque chose qui se rapproche de l’espace colorimétrique Rec. 2020 complet, et il faudra certainement attendre les dalles 12-bit pour ça.

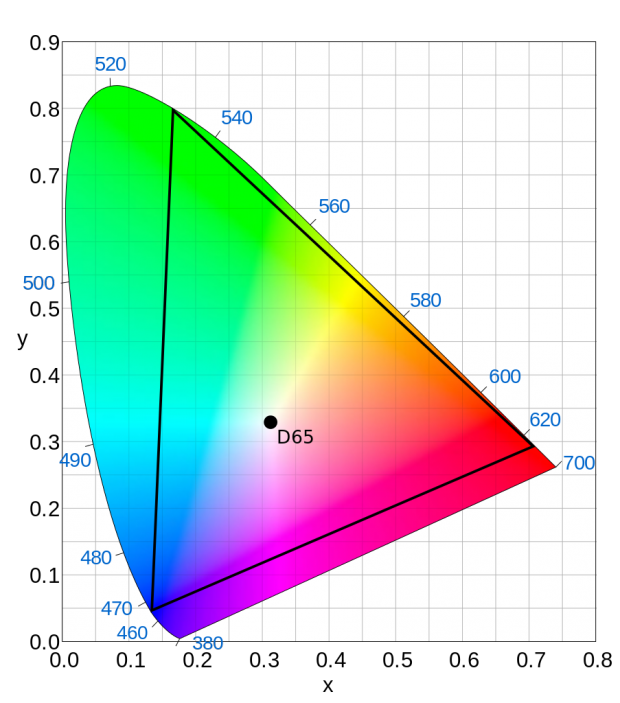

Voici le gamut colorimétrique Rec. 2020, qui est encore plus large que le DCI-P3. Il faudra du temps avant de voir l’arrivée d’écrans capable de l’afficher en entier…

De fait, il faudra plusieurs années avant de commencer à réellement entendre parler de Rec. 2020, et la compatibilité des appareils actuels n’est en réalité là que pour essayer de permettre aux appareils de tenir dans le temps pour plus tard. En réalité, la seule chose importante pour le moment est la capacité de l’écran à afficher le gamut DCI-P3.

Que sont HDR10 et Dolby Vision ?

Un autre des standards HDR les plus communs que vous verrez sur les cartons de télés et d’écrans est HDR10. Celui-ci a été adopté par pratiquement toutes les télés HDR disponibles actuellement (ainsi que les PS5 et Xbox series X) et est le standard par défaut pour les Blu-Rays Ultra HD – pratique si vous voulez vous assurer que votre télé peut réellement profiter pleinement de la collection de Blu-Ray Ultra HD que vous vous créez.

En termes d’affichage, l’HDR10 inclue la gestion des couleurs 10-bit, de l’espace colorimétrique Rec. 2020, et d’une luminosité maximale de 10 000 cd/m². Encore une fois, l’HDR10 est peut-être compatible avec tout cela, mais ça n’implique pas forcément qu’un écran soit capable de le faire réellement dans la pratique.

Exemple concret : DolbyVision. Ce standard est compatible avec les couleurs 12-bit (qui n’existent pas encore réellement) ainsi qu’un luminosité max de 10 000 cd/m² et le gamut colorimétrique Rec. 2020. Comme je l’ai dit plus tôt, je suis certain qu’un jour ces standards impliqueront une réelle différence sur ce que vous voyez sur vos appareils, mais pour l’instant, le résultat est le même.

Un élément clé à prendre en compte est que la principale différence entre l’HDR10 et DolbyVision (et maintenant HDR10+, qui est une version améliorée d’HDR10) est la façon dont ils gèrent les métadonnées HDR – la façon dont les films et les lecteurs Blu-Ray communiquent avec la télé pour interpréter les signaux. Cela peut être utile si vous achetez un écran HDR10 par exemple, avec pour but de le brancher à un lecteur Blu-Ray compatible HDR10, mais sinon, tous ces standards peuvent globalement être oubliés pour l’achat de votre télé.

En effet, il semble que les standards VESA DisplayHDR soient en train de devenir la base pour l’HDR sur PC, avec les standards Nvidia G-Sync HDR et AMD FreeSync Premium Pro opérant de l’autre bout, de la même façon que fonctionnent les technologies G-Sync et FreeSync.

De quoi ai-je besoin pour l’HDR sur PC ?

Avec toutes ces informations en tête, le meilleur moyen de profiter de l’HDR sur PC à l’heure actuelle est d’acheter un écran aux caractéristiques suivantes :

- Une luminosité maximale élevée, idéalement de 1000 cd/m², mais au minimum de 600 cd/m²

- Couverture minimale de 90 % du gamut colorimétrique DCI-P3

- Une dalle 10-bit (ou 8-bit + 2-bit)

Le souci vient des écrans qui annoncent être compatibles HDR, alors qu’en réalité tout ce qu’ils ont est l’extension de couverture du gamut colorimétrique. Cela ne pose pas de problème si vous cherchez simplement un écran plus précis avec de belles images sans dépenser trop d’argent – le BenQ EW277HDR en est un excellent exemple. Mais pour ceux qui veulent profiter d’une vraie expérience HDR, la luminosité maximale est fondamentale.

À l’heure actuelle, les seuls écrans à vraiment atteindre ces caractéristiques (et qui sont réellement trouvables) sont l’Asus ROG Swift PG27UQ et l’Acer Predator X27 – et vous aurez malheureusement à lâcher une belle somme pour vous en procurer un, avec l’Asus PG27UQ se négociant à plus de 2000 €. Le Samsung CHG90 est un autre bon choix si vous cherchez aussi un écran Super Ultrawide, mais sa luminosité maximale est légèrement plus faible. Il coûte également un bras avec son prix de 1000 €.

Lire la suite:

Meilleur Ecran PC Gamer

Meilleur Ecran pour la Retouche Photo

Les Meilleurs Ecrans PC 4K

GTemps vit grâce à ses lecteurs. Lorsque vous achetez quelque chose via un lien sur notre site, nous pouvons percevoir une commission d’affilié. En apprendre plus.

Laisser un commentaire